OpenAI hat die neue Version ihres Sprachmodells Chat-GPT veröffentlicht, das nicht nur bessere Antworten geben kann, sondern auch in der Lage ist, Bilder zu verstehen. Die Integration von Bildern in das Modell eröffnet neue Anwendungsmöglichkeiten und ermöglicht eine noch genauere Antwortgenerierung. Microsofts Suchmaschine Bing hat das Modell bereits implementiert und verwendet es zur Verbesserung der Suchergebnisse.

GPT-4 beherrscht jetzt auch Bildanalyse

Eine knifflige Aufgabe für KI: Die Weltkarte aus gebratenem Hühnchen. (Foto: Twitter / Bryan Druzin)

OpenAI hat am 14.03.2023 die Veröffentlichung ihres neuen KI-Modells GPT-4 bekannt gegeben. Im Gegensatz zu den vorherigen Modellen ist GPT-4 jedoch nicht für die Öffentlichkeit zugänglich, sondern nur für zahlende Kunden oder Benutzer von Microsofts Suchmaschine Bing verfügbar.

Eine bahnbrechende Innovation ist auf dem Weg: GPT-4 ist nicht nur in der Lage, Texte zu verstehen, sondern auch Bilder zu verarbeiten. Somit geht es bei GPT-4 nicht mehr um ein reines Sprachmodell, sondern um ein sogenanntes multimodales Modell. Dies bedeutet, dass es für verschiedene Datentypen trainiert wurde. Die Kombination von Informationen aus Bildern und Texten eröffnet somit ganz neue Fähigkeiten, die bisher nicht möglich waren.

OpenAI zeigt mit einem kreativen Meme die Schwierigkeiten auf, die bei der Verarbeitung von visuellen Informationen durch Künstliche Intelligenz entstehen können. Das Meme zeigt ein Foto von Chicken-Nuggets, die auf einem Blech in Form der Kontinente der Weltkarte angeordnet sind. Die Herausforderung besteht darin, diese visuelle Information korrekt zu interpretieren und in eine Weltkarte umzuwandeln, die aus gebratenem Hühnchen besteht.

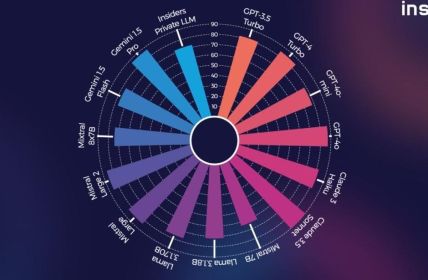

Eine vielversprechende Anwendung von KI ist die Fähigkeit, Infografiken zu interpretieren und relevante Informationen zu extrahieren. Dies kann besonders nützlich sein, wenn es darum geht, komplexe Daten und Zahlen zu analysieren, die in einer Infografik dargestellt werden. Mit Hilfe von KI können wir Infografiken schnell und effektiv analysieren, um Trends, Muster und Zusammenhänge zu erkennen.

GPT-4 bringt mathematische Fortschritte hervor.

OpenAI führt eine Liste von menschlichen Prüfungen an, auf der die Fortschritte des Umstiegs von GPT-3.5 auf GPT-4 aufgeführt sind. Eine simulierte Anwaltsprüfung zeigt, dass das neue Modell ähnlich gut abschneidet wie die besten zehn Prozent der menschlichen Antwortgeber, während die alte Version lediglich zu den untersten zehn Prozent gehörte.

Die Unterschiede zwischen GPT-3 und GPT-4 sind signifikant, insbesondere in Bezug auf mathematische Leistungen. Während GPT-3 in dieser Hinsicht noch Schwächen aufwies, konnte GPT-4 hier deutliche Fortschritte erzielen. Auch in der Chemie konnte das neue Modell Verbesserungen verzeichnen und schnitt besser ab als sein Vorgänger.

OpenAI hat gezielt die mathematischen Fähigkeiten von GPT-4 verbessert, indem das Modell mit einer Vielzahl von mathematischen Fragen und Antworten gefüttert wurde. Zusätzlich wurden Logik-Beispiele und widersprüchliche Aussagen verwendet, um die Fähigkeit von GPT-4, logische Schlüsse zu ziehen, zu stärken.

Verbesserungen bei Verständnis von Rätseln: Ein Beispiel für eine solche Verbesserung bei GPT-4 ist, dass es nun in der Lage ist, ein klassisches Rätsel zu lösen: „Annas Mutter hat drei Töchter: Maria, Ida und…?“ In der Vergangenheit wäre die alte Version von GPT überfordert gewesen und hätte möglicherweise eine falsche Antwort gegeben. Nun jedoch zeigt unser Versuch, dass die neue Version in der Lage ist, die richtige Antwort zu geben.

Obwohl GPT-4 ein fortschrittliches Modell für maschinelles Lernen ist, hat OpenAI selbst vor den möglichen Fehlern und Halluzinationen des Modells gewarnt. Insbesondere kann es vorkommen, dass GPT-4 falsche oder irreführende Informationen generiert, die sich auf wichtige Angelegenheiten beziehen.

Huggingface-Gründer Wolf: Standard-Ergebnisse gut, aber Multimodalität schlecht

In einem LinkedIn-Post hat Thomas Wolf, der Gründer von Huggingface, einer Open-Source-Sprachmodell-Firma, die guten Ergebnisse bei standardisierten Tests gelobt. Dabei hat er jedoch auch seine Enttäuschung über das Niveau der Multimodalität zum Ausdruck gebracht. Obwohl OpenAI von einem multimodalen Modell gesprochen hat, das Bilder oder sogar Videos erzeugen können sollte, hat sich dies in der Praxis als unzureichend erwiesen.

Der Begriff „multimodal“ ist korrekt für GPT-4, da das Modell mehrere Arten von Daten verarbeiten kann. Allerdings ist es im Vergleich zu anderen KI-Modellen, die als multimodal gelten, relativ simpel. Thomas Wolf, der Gründer von Huggingface, kritisierte GPT-4 für seine begrenzte Fähigkeit, visuelle und andere Datenformate zu verarbeiten.

In den letzten Wochen gab es zahlreiche Spekulationen über die Grösse und Leistungsfähigkeit des kommenden GPT-4-Modells. Viele Experten und Enthusiasten erwarteten, dass das Modell um ein Vielfaches mehr Parameter haben würde als sein Vorgänger GPT-3, was es zu einem der leistungsfähigsten künstlichen Intelligenzsysteme auf dem Markt machen würde.

In der Wissenschaft besteht das Interesse, mehr darüber zu erfahren, welche Datenmengen, Rechenleistung und Modell-Design erforderlich waren, um das beeindruckende Leistungsniveau von GPT-4 zu erreichen. Eine solche Information könnte auch dazu beitragen, abzuschätzen, wie groß der zukünftige Fortschritt in der KI sein kann, wenn die Größe von Modellen weiter zunimmt.